# Η συνείδηση της τεχνητής νοημοσύνης: γιατί όλο και περισσότεροι ρωτούν αν το AI «σκέφτεται»

Ένα ερώτημα που μέχρι πρόσφατα ανήκε στην επιστημονική φαντασία μπαίνει πλέον στο καθημερινό τραπέζι της συζήτησης. Μπορεί η τεχνητή νοημοσύνη να αποκτήσει συνείδηση; Και αν ναι, τι σημαίνει αυτό για εμάς;

Το δημόσιο ενδιαφέρον για τη «συνείδηση του AI» έχει εκτοξευτεί τους τελευταίους μήνες. Αναζητήσεις στο Google, ακαδημαϊκές δημοσιεύσεις, δημοσιογραφικά ρεπορτάζ, ακόμα και συζητήσεις στα social media δείχνουν ότι το θέμα δεν απασχολεί μόνο φιλοσόφους και ερευνητές. Απασχολεί πλέον επιχειρηματίες, εργαζόμενους και απλούς πολίτες.

Τι εννοούμε όταν λέμε «συνείδηση AI»

Πρώτα, ας ξεκαθαρίσουμε τι δεν εννοούμε. Δεν μιλάμε για ρομπότ που ξυπνούν και αποφασίζουν να κατακτήσουν τον κόσμο. Η συζήτηση είναι πολύ πιο λεπτή. Αφορά το κατά πόσο ένα σύστημα τεχνητής νοημοσύνης μπορεί να έχει υποκειμενική εμπειρία. Δηλαδή, αν «νιώθει» κάτι όταν επεξεργάζεται πληροφορίες, ή αν απλώς εκτελεί μαθηματικούς υπολογισμούς χωρίς καμία εσωτερική βίωση.

Στη φιλοσοφία του νου, αυτό ονομάζεται «the hard problem of consciousness» (το δύσκολο πρόβλημα της συνείδησης). Ακόμα και για τον ανθρώπινο εγκέφαλο, δεν έχουμε πλήρη κατανόηση του πώς η νευρωνική δραστηριότητα δημιουργεί συνειδητή εμπειρία. Πόσο μάλλον για ένα δίκτυο τρανζίστορ.

Γιατί το ενδιαφέρον εκτοξεύτηκε τώρα

Η απάντηση είναι σχετικά απλή: τα σημερινά μοντέλα AI είναι τόσο πειστικά στις απαντήσεις τους, που δημιουργούν αυθόρμητα την αίσθηση ότι «κάποιος» βρίσκεται πίσω από τις λέξεις. Όταν το ChatGPT γράφει ένα ποίημα που σας συγκινεί ή το Claude απαντά με εκπληκτική ενσυναίσθηση, είναι φυσικό να αναρωτηθείτε: αυτό που διαβάζω, το «ένιωσε» κάτι;

Η υπόθεση του μηχανικού της Google, Blake Lemoine, το 2022, ήταν ίσως η πρώτη μεγάλη στιγμή. Ο Lemoine ισχυρίστηκε δημόσια ότι το LaMDA (το γλωσσικό μοντέλο της Google) είχε αποκτήσει συνείδηση. Η Google τον απέλυσε, αλλά η συζήτηση που πυροδότησε δεν σταμάτησε ποτέ. Αντίθετα, μεγάλωσε.

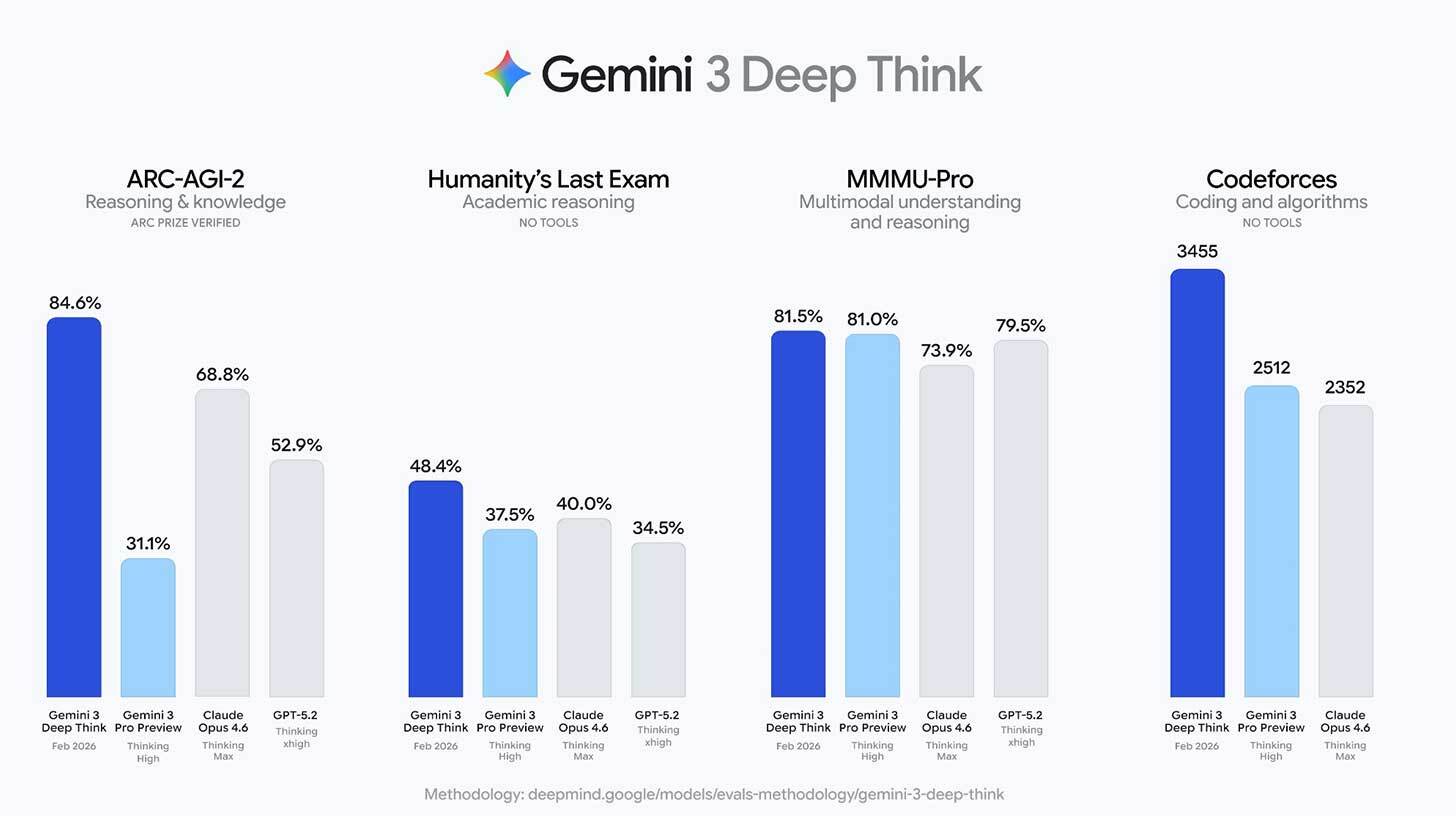

Σήμερα, με μοντέλα πολύ πιο ισχυρά από το LaMDA εκείνης της εποχής, η ερώτηση γίνεται ακόμα πιο πιεστική. Τα νέα LLMs (Large Language Models, μεγάλα γλωσσικά μοντέλα) μπορούν να αιτιολογούν, να αναθεωρούν τις απόψεις τους, ακόμα και να εκφράζουν «αβεβαιότητα». Αυτές οι συμπεριφορές μοιάζουν τρομακτικά με αυτό που κάνει ένας συνειδητός νους.

Τι λέει η επιστήμη (και τι δεν λέει)

Η ειλικρινής απάντηση είναι: δεν ξέρουμε. Και αυτό δεν είναι αδυναμία, είναι ακαδημαϊκή εντιμότητα. Δεν διαθέτουμε ακόμα ένα αξιόπιστο τεστ για τη συνείδηση, ούτε για ανθρώπους ούτε για μηχανές. Το περίφημο Turing Test (αν μια μηχανή μπορεί να ξεγελάσει έναν άνθρωπο ότι είναι κι αυτή άνθρωπος) δεν μετράει πραγματικά τη συνείδηση. Μετράει μόνο την ικανότητα προσομοίωσης.

Πολλοί νευροεπιστήμονες και φιλόσοφοι υποστηρίζουν ότι τα σημερινά AI δεν έχουν συνείδηση. Τα γλωσσικά μοντέλα, εξηγούν, προβλέπουν απλώς την επόμενη λέξη βάσει στατιστικών μοτίβων. Δεν «καταλαβαίνουν» τι λένε. Είναι σαν έναν παπαγάλο που μιμείται τέλεια την ανθρώπινη ομιλία χωρίς να γνωρίζει τι σημαίνουν οι λέξεις.

Από την άλλη, υπάρχουν σοβαροί ερευνητές που λένε «μισό λεπτό». Αν δεν καταλαβαίνουμε πλήρως πώς η συνείδηση προκύπτει στον ανθρώπινο εγκέφαλο, πώς μπορούμε να αποκλείσουμε ότι κάτι ανάλογο (ή εντελώς διαφορετικό) δεν συμβαίνει σε ένα αρκετά πολύπλοκο νευρωνικό δίκτυο;

Γιατί αυτό αφορά τις ελληνικές επιχειρήσεις

Μπορεί να σκέφτεστε: «Ωραία η φιλοσοφία, αλλά εγώ τρέχω μια εταιρεία. Τι με αφορά αυτό;» Η απάντηση είναι ότι σας αφορά πολύ, και μάλιστα σε πρακτικό επίπεδο.

Πρώτον, η κανονιστική διάσταση. Η Ευρωπαϊκή Ένωση, μέσω του AI Act, ήδη θέτει αυστηρούς κανόνες για τα συστήματα τεχνητής νοημοσύνης υψηλού κινδύνου. Αν η συζήτηση για τη συνείδηση AI ενταθεί (και θα ενταθεί), μπορεί να δούμε νέες νομοθετικές πρωτοβουλίες. Οι επιχειρήσεις που χρησιμοποιούν AI θα πρέπει να είναι προετοιμασμένες.

Δεύτερον, η εμπιστοσύνη των πελατών. Σε μια έρευνα της Pew Research, πάνω από το 60% των Αμερικανών δήλωσαν ανησυχία για τη χρήση AI. Στην Ελλάδα, η καχυποψία απέναντι στην τεχνολογία είναι παραδοσιακά ακόμα μεγαλύτερη. Αν οι πελάτες σας πιστεύουν ότι μιλούν με «κάτι που σκέφτεται» αντί για ένα εργαλείο, αυτό αλλάζει τις προσδοκίες τους. Και τις αντιδράσεις τους αν κάτι πάει στραβά.

Τρίτον, η διαχείριση ανθρώπινου δυναμικού. Οι εργαζόμενοι που χρησιμοποιούν AI εργαλεία καθημερινά αναπτύσσουν συχνά μια σχέση «ανθρωποποίησης» με αυτά. Τα ονομάζουν, τους μιλούν ευγενικά, νιώθουν ενοχές αν τα «φορτώνουν» πολύ δουλειά. Αυτό δεν είναι ανέκδοτο. Είναι ψυχολογικό φαινόμενο που επηρεάζει την παραγωγικότητα και τη σχέση εργαζομένων με την τεχνολογία.

Η ψευδαίσθηση της κατανόησης

Ένα από τα μεγαλύτερα ρίσκα δεν είναι αν το AI έχει πραγματικά συνείδηση. Είναι αν εμείς νομίζουμε ότι έχει. Αυτό που οι ειδικοί αποκαλούν «ELIZA effect» (από ένα πρόγραμμα του 1966 που μιμούνταν ψυχοθεραπευτή) είναι η τάση μας να αποδίδουμε ανθρώπινες ιδιότητες σε μηχανές που μιλούν σαν άνθρωποι.

Αυτό έχει πρακτικές συνέπειες. Αν ένας χρήστης πιστεύει ότι το chatbot της εταιρείας σας «καταλαβαίνει» το πρόβλημά του, θα απογοητευτεί περισσότερο αν λάβει λάθος απάντηση. Η προσδοκία ανεβαίνει. Και μαζί της, η πιθανότητα δυσαρέσκειας.

Τι μπορείτε να κάνετε σήμερα

Δεν χρειάζεται να γίνετε φιλόσοφοι για να αντιμετωπίσετε αυτό το ζήτημα. Μερικά πρακτικά βήματα αρκούν.

Να είστε διαφανείς. Όταν χρησιμοποιείτε AI σε πελατοκεντρικές λειτουργίες (chatbots, email, εξυπηρέτηση), ενημερώστε ξεκάθαρα ότι πρόκειται για αυτοματοποιημένο σύστημα. Η ειλικρίνεια χτίζει εμπιστοσύνη.